مقدمه ای بر مفهوم داده های بزرگ و ابرداده ها

همانطور که می دانید دادههایی که ما تولید میکنیم پایه و اساس اطلاعات بشر هستند. این دادهها درباره موضوعات و حوزههای مختلف ممکن است به تنهایی دارای ارزش نباشند. اما تجمیع، سازماندهی و تجزیه و تحلیل آنها است که باعث ایجاد ارزش میشود. در این دنیای دیجیتال، دادهها از منابع متفاوتی تولید میشوند، همچنان که رشد سریع فناوریهای دیجیتال منجر به افزایش نرخ تولید و ایجاد حجم انبوهی از دادهها ( ابرداده ها ) شده است. این دادهها از تراکنشهای آنلاین، ایمیل ها، ویدیوها، صوت ها، متون، اسناد، تصاویر، کلیک بر روی لینک ها، پستها و صدها عمل دیگری که ما در طول شبانه روز انجام میدهیم تولید میشوند.

هر روزه با افزایش تعداد دستگاهها، ماشینها و اپلیکیشنهای متصل به اینترنت که با یکدیگر ارتباط برقرار میکنند، دفترها به طرز عجیبی در حال جمع کردن انباشته هایی از اطلاعات هستند. بیشترین درصد داده ها در دنیا طی همین دو سال گذشته تولید شدهاند. نیاز به ذخیرهسازی، جستوجو در آنها و معنا دادن به این حجم از داده سبب شده سرمایهگذاریها بسیار وسیعی در ابعاد گوناگون در زمینه اطلاعات و پایگاه داده در سراسر جهان انجام شود. همچنان که شرکت تحقیقاتی IDC ادعا دارد، حدود 2.9 میلیون پایگاه سروری در ایالات متحده وجود دارد و البته که این تنها شروع کار است.

درباره تجهیزات ذخیره سازی در کاریز بیشتر بدانید …

حجم داده های بزرگ

این حجم غیر قابل باور دادهها به ابرداده ها، دادههای حجیم یا بزرگ دادهها (Big data) معروف شده است. نکته قابل توجه آن است که ابرداده ترجمه متداول و پرکاربرد عبارت Big Data محسوب میشود، در حالیکه معادل فارسی برگزیده شده توسط فرهنگستان زبان و ادب پارسی «مِهداده» است.

مسئله ابرداده به مجموعه ای از دادههای بزرگ و پیچیده باز میگردد که پردازش آنها با استفاده از سیستمهای پایگاه داده یا نرمافزارهای پردازش داده سنتی کاری بسیار دشوار و دور از ذهن است. این دادهها در قالبهای ساختار یافته (structured)، ساختار نیافته (unstructured) و نیمه ساختار یافته (semi-structured) و در اندازه پتابایت (PB)، اگزابایت (EB)، زتابایت (ZB) و یا بیشتر وجود دارند. با اینکه دغدغه حجم ابردادههای تولید بشر به طور جدی از دهههای ۶۰ و ۷۰ میلادی آغاز شد اما میتوان گفت این اصطلاح، مفهوم جدیدی است.

در واقع ابتدایی ترین هدف از تحلیلهای ابرداده، پردازش حجم بسیار زیاد با نرخ رشد بالا، متنوع و همراه با صحت دادهها با بهرهگیری از روشهای هوشمند محاسباتی و سنتی متعدد می باشد. این مسئله به تصمیمسازی پیشرفته و بهینهسازی در عین خلاقیت و کاهش هزینه کمک میکند.

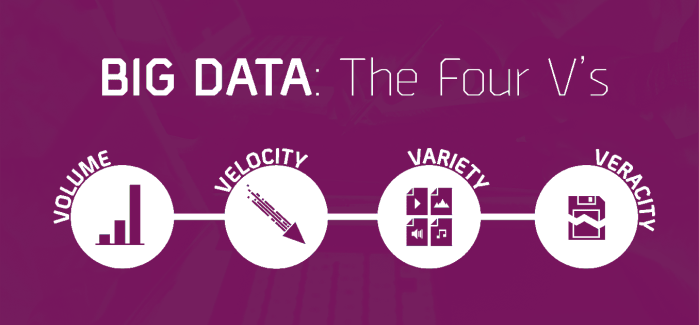

چهار “v” مهم در داده های بزرگ و ابرداده ها

حجم دادهها (Volume): با بیگ دیتا شما با حجم زیادی از دادههای بدون ساختار و با تراکم پایین مواجه هستید. این دادهها میتوانند شامل دادههایی با مقادیر نامعلوم مثل دادههای توییتر، کلیکهای مربوط به یک صفحه وب یا دادههای مربوط به یک حسگر باشد. برای برخی سازمانها این به معنی دهها ترابایت داده است.

سرعت (Velocity): سرعت به نرخ دریافت و همچنین در برخی موارد انجام اعمالی بر روی دادهها اطلاق میشود. برای مثال برخی از ابزار هوشمند مبتنی بر اینترنت نیاز به دریافت اطلاعات به صورت بلادرنگ و البته انجام پردازشها به صورت بلادرنگ دارند.

تنوع (Variety): این جنبه به انواع دادههایی که در بیگ دیتا مورد استفاده قرار میگیرند اشاره دارد. دادههای سنتی اغلب ساختار یافته بودند و در پایگاه دادهای رابطهای ذخیره میشدند. اما با ظهور بیگ دیتا، دادهها بدون ساختار شدند. دادههایی مثل صدا، متن و تصویر که به پردازشهای تکمیلی جهت برداشت معانی خاص از آنها نیازمند هستیم. علاوه بر این، ارزش و اعتبار دادهها نیز طی سالیان گذشته مورد توجه قرار گرفته است.

صحت (Veracity): با رشد سریع داده ها از نظر حجم و تنوع، امکان وجود داده های نادرست در آنها نیز افزایش می یابد در نتیجه اگر ورودی قابل اعتماد نباشد نمی توان به اطلاعات استخراج شده از آن اعتماد کرد.

اما شرکتها نیاز دارند با یک روش هوشمند، ارزان و پیشرو، حجم وسیع دادههای خود را مدیریت کنند. یکی از راهکارها استفاده از ابزارهایی مانند هادوپ است، چارچوبی نرمافزاری و منبع آزاد که برای پردازش داده ها در مقیاس بزرگ مورد استفاده قرار میگیرد. درواقع هادوپ یک فریم ورک یا مجموعهای از نرم افزارها و کتابخانههایی است که ساز و کار پردازش حجم زیادی از دادههای توزیع شده را فراهم میکند. این مجموعه از سال ۲۰۰۶ راه اندازی شده است.

میتوان هادوپ را به یک سیستم عامل تشبیه کرد که طراحی شده تا بتواند حجم زیادی از دادهها را بر روی ماشینهای مختلف پردازش و مدیریت کند. هادوپ توانست در سال 2008 با پردازش 1 ترابایت داده در 202 ثانیه رکورد سریعترین سیستم پردازش را بشکند و حتی بعدها اعلام کرد که این زمان را به 68 ثانیه کاهش داده است.

همانطور که پیش تر اشاره کردیم منابع تولیدی کلان داده ها مدیای اجتماعی، داده های ماشین مانند رایانه ها و وسایل پزشکی، حسگرها و اینترنت اشیا یا به اصطلاح IOT می باشد. بر همین اساس میتوان کاربرد کلان داده ها به طور اخص میتوان در سازمانها و شرکتها، شبکه های اجتماعی و IOT جستجو کرد. در این میان داده های بزرگ با چالش هایی مانند مشکل در نمایش داده ها، کاهش انباشت و فشرده سازی، مکانیزم تحلیلی، سری بودن داده ها و کنترل و تنظیم انرژی روبرو هستند.

نهایتا و با وجود این حجم از تبلیغات، ابرداده ها روزهای نخستین خود را طی میکند. به گفته IDC، در سال گذشته تنها 22 درصد اطلاعات دیجیتال قابل تحلیل بودند که 5 درصد آن مورد تحلیل قرار گرفت. همچنان حجم وسیعی از دادهها در سیستمهای بخشبندی شده ذخیره شده که خارج از بررسی است و این امر اطلاعات را بدون استفاده ساخته است. از آنجایی که سازمانها از تکنولوژیهای جدید و ابزارهای تحلیل کارآمدی برای پایگاهها داده استفاده میکنند، میتوان گفت آینده روشنی برای در انتظار کلان داده هاست.

این مقاله را با دوستان خود به اشتراک بگذارید:

امکان نظردهی برای این مطلب غیرفعال است.